原本每天上一讲就写一篇后记,但既要写学生成长记录,又要写这个,结果每天都得压缩睡眠时间。

再这样下去身体吃不消,就决定攒到一起写。

1. 简单回归模型 - 决定系数

在简单回归模型中,仅凭线性回归曲线或回归系数,并不能了解数据的整体形态。

例如,下面这样的两组数据,它们的回归曲线的截距和斜率是相同的。

但这两组数据本身却并不相同。

决定系数是将针对线性回归的 Y 值差异平方后加总得到的指标。

通过它可以知道实际数据点与预测直线之间相差有多远。

如果决定系数为 0,则表示回归模型对因变量整体变异的解释率为 0%;若为 1,则表示回归模型对因变量整体变异的解释率为 100%。

2. 多元回归模型

当一个因变量不只依赖于一个自变量时,就使用多元回归模型。

下面是把事后分数与事前分数、年龄之间的关系用三维图表示出来的例子。

在这里进行多元回归分析的话,会得到一个平面。

需要注意的是,这表示在控制一个自变量的情况下,说明另一个自变量变化所带来的因变量变化。

3. 回归模型的比较与变量选择

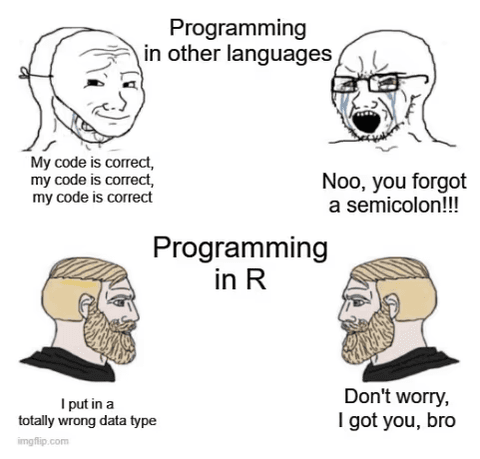

在回归模型中,变量加得越多,R 值就会越大。

因此,不使用单纯的 R 值,而是使用校正后的 R 值等指标。

这是一种在变量每增加一个就进行扣分,从而缩小 R 值的方式。

在选择回归模型时,可以通过一步步增加变量来考虑采用哪一种模型。

这就叫做分层回归分析(层级回归分析)。

也可以在不增加变量的情况下,只用一个变量,画出二次、三次曲线,使该变量与因变量之间的关系变得更复杂。

4. 后记

原以为论文中使用的分析方法会非常难,没想到了解之后发现好像也没有那么难。

可能是因为是以前就知道的分析方式,所以更有亲切感。

不过,实战中是否也会这样顺利呢……?

每天都在思考该怎么写论文,但对于要深挖哪个主题却还是没有什么头绪。

希望等这次研修结束的时候,已经找到了自己的研究问题。

댓글을 불러오는 중...