虽然听了很多讲座,但我觉得与其通过听讲座学习,不如自己去探索、学习,这样记得更久,学到的东西更多。

所以听说在Inflearn上有一个“从零开始制作LLM”的完整阅读挑战,便立即报名了。

就像上次在Sailing 99中认识到算法的重要性一样,我希望这次也能学到很多东西。

1. 内容摘要

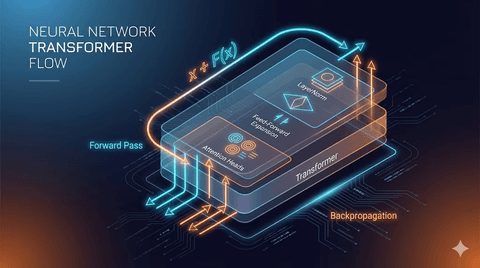

归纳第1章的要点,LLM的开始源于Transformer结构。

在Transformer结构中,对语言进行编码、对目标语言进行解码,生成翻译后的语言。

编码是将语言进行标记化和向量化的过程,而解码则是输出语言的过程。

如果仅将解码摘出来编程,就成为GPT这样的服务。GPT通过重复执行解码器直到句子完成。

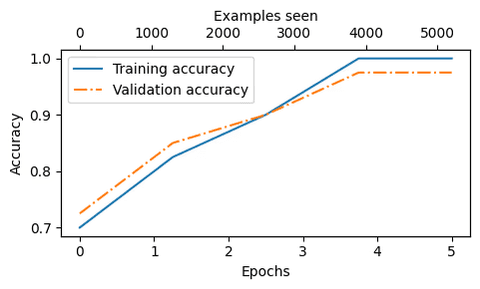

为了制作这种语言模型,需要学习数据。

利用开源的学习数据,建立模型,通过微调可以创建各种LLM服务。

2. 感想

通过阅读书籍,我可以准确了解LLM的结构。

BERT在学习向量化时出现,使用One-Hot Encoding进行编码等,都是单词的向量化技术之一。

仅凭学到这一点,就觉得参加挑战是值得的。

第二章也打算精读后再试试写。

댓글을 불러오는 중...