I recently saw a question about stellar luminosity classes while solving the September mock exam.

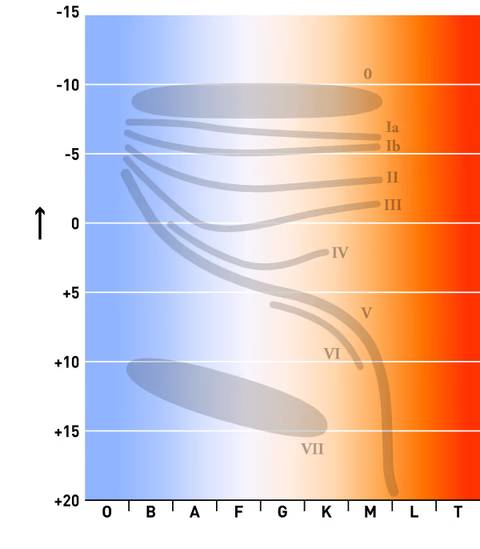

I decided to write about luminosity classes, going a step further than the high school curriculum to explain why line widths differ with luminosity classes.

The EBS reference book states the following.

This article delves deeper into the content below. Because it's lengthy, I've divided it into two topics.

The first is how to determine the line width of absorption lines, and the second is how to determine luminosity classes.

If you're only interested in knowing what luminosity classes are, go to the link in the conclusion.

You can determine a star's size by comparing the line width of absorption lines in spectra of stars with the same spectral type, which helps ascertain their luminosity.

- EBS College Entrance Exam Special Earth Science 1 P.145 -

Reading the following article first will greatly aid your understanding of this piece.

1. Spectral Lines and Absorption Line Width

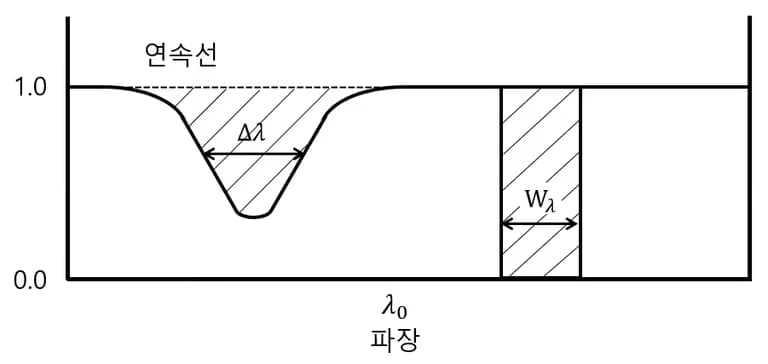

First, it's important to understand how spectral lines, which we commonly observe, are formed. By spectroscopically observing the intensity (flux) of starlight by wavelength, the following graph is displayed.

When displaying the intensity of starlight by wavelength, it typically follows the form of a Planck curve, with lower intensity in wavelengths absorbed by the star's atmosphere.

Using the general intensity expected without absorption (Fc) as a reference and employing (intensity by wavelength/general intensity) (Fλ/Fc), the spectrum's outline is calculated.

Applying this to all wavelengths forms a single line from the star's intensity.

Simply put, it indicates the degree to which starlight is absorbed relative to a baseline of 1.

The width at which they form around a central wavelength (λ0) is defined as the absorption line's width (∆λ).

The graph constructed when plotting the intensity matching the absorption line's area centered on the central wavelength defines its equivalent width (Wλ).

Depicting the equivalent width of absorption lines for each atom yields the familiar absorption spectrum.

The curriculum's absorption spectrum intensity refers to the equivalent width.

However, what luminosity classes discuss is the absorption line's width.

So, what factors determine the absorption line's width?

2. Factors Increasing Absorption Line Width

As explained above, absorption lines don't appear as thin lines but over a wider wavelength range.

For example, consider absorption lines formed as hydrogen atoms transition from energy level n=2 ➜ n=3.

The central wavelength of the absorption line would be λ=656.3 nm.

However, this absorption occurs over a range, not just at λ=656.3 nm.

Several reasons account for why absorption lines don't appear as pure lines.

Due to reasons like the following, absorption lines appear spread broadly around a centered wavelength; this width from the central wavelength is called the absorption line width.

1) Natural Line Width Increase

Due to the Heisenberg Uncertainty Principle, atomic energy levels can’t be precisely determined.

Thus, absorption lines from many atoms also lead to line width around a central wavelength.

2) Thermal Doppler Line Width Increase

Gas atoms are in constant motion.

Atomic velocity relates to temperature and chemical composition.

Line width increases due to the Doppler effect related to directional motion.

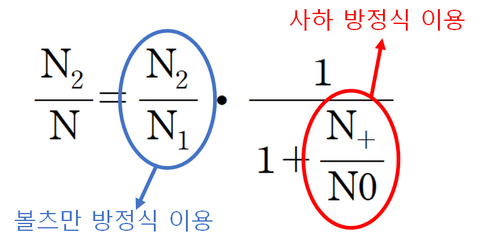

3) Collision Line Width Increase (Stark Effect)

The energy levels of atoms change due to neighboring atoms.

More neighboring atoms, or closer ones, create varied energy levels, causing increased line width.

Therefore, collision line width increases more with higher density (or pressure).

4) Zeeman Effect

When atoms are in a strong magnetic field, energy levels split into three or more.

In stars with strong magnetic fields, the Zeeman effect causes line width to increase.

3. Summary and Conclusion

Stellar absorption lines don't appear as thin lines but with width, known as line width.

Absorption line width is influenced by four factors (natural line width increase, thermal Doppler effect, Stark effect, Zeeman effect).

The stellar luminosity class relates to the Stark effect among the four factors. The higher the pressure of the gas forming the absorption line, the wider it becomes, known as the Stark effect.

This article explored how absorption line width is determined and what factors affect it.

To learn how absorption line width helps determine luminosity classes, read the next article.

댓글을 불러오는 중...