6장은 분류를 위한 미세 튜닝하기이다.

예제로 나오는 것은 스팸 분류기 만들기.

스팸 분류기는 이것이 스팸인지, 스펨이 아닌지를 분류하는 것이므로 출력의 결과가 0, 1과 같은 값으로 나와야 한다.

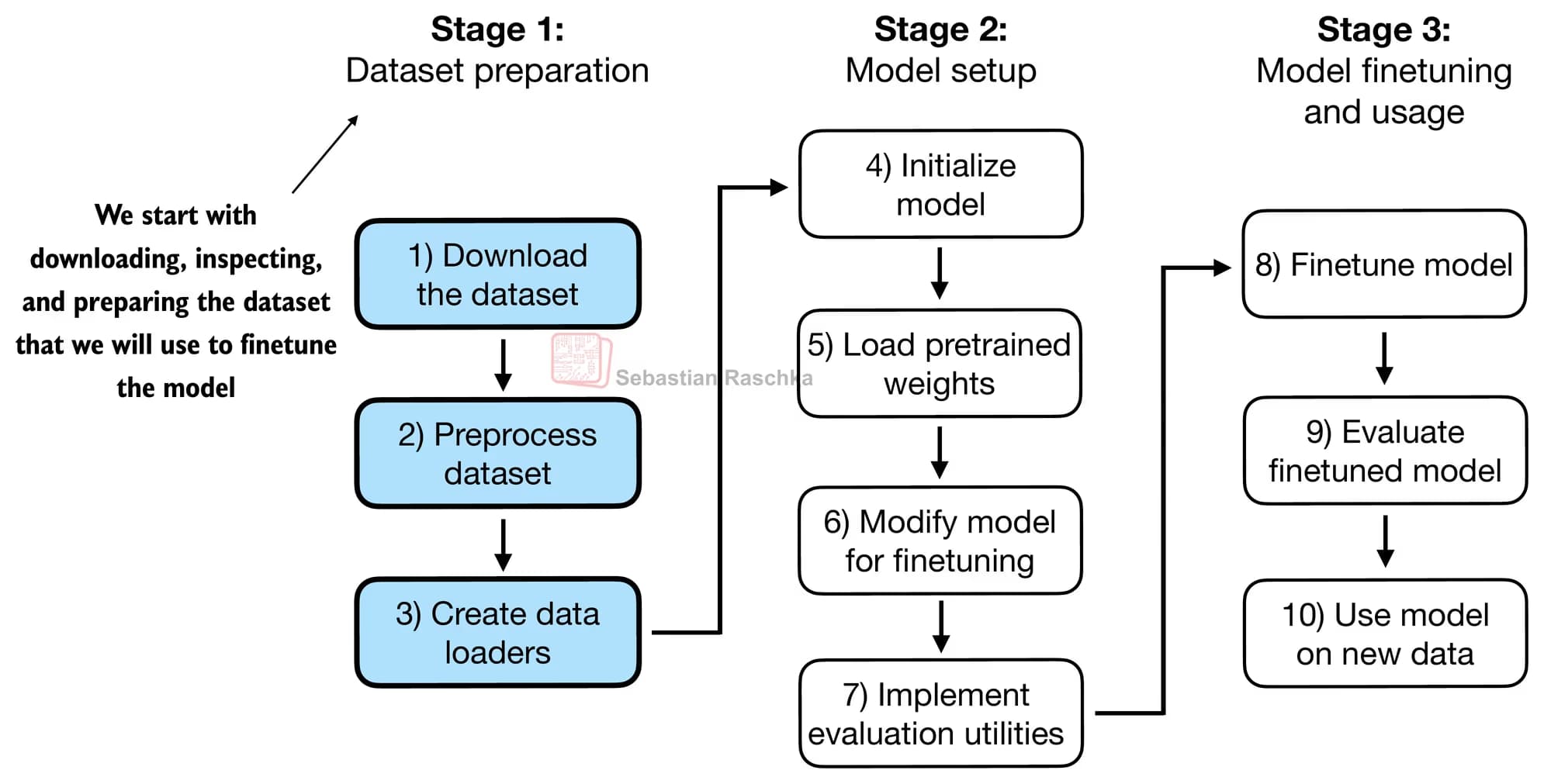

1. 미세튜닝의 순서

미세 튜닝의 과정은 모델을 훈련시키는 과정과 비슷하다.

데이터셋을 준비하고, 가중치 값을 로드 한 뒤 훈련시키고 평가한다.

조금 다른점이 있다면 출력층을 0(스팸 아님)과 1(스팸)으로 매핑하는 과정이 있다는 것.

이렇게 나온 텐서들 중 가장 많은 정보를 담고 있는 마지막 텐서를 바탕으로 스팸 유무를 출력하도록 한다.

마지막으로 손실은 크로스 엔트로피로 산출한다.

2. 지도 학습 데이터로 모델 미세 튜닝하기

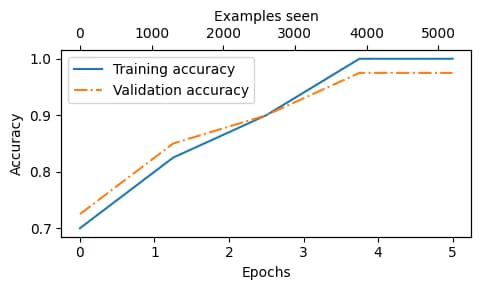

데이터를 훈련 데이터와 검증 데이터로 나누고, 이를 여러번의 에포크를 통해 학습시킨다.

훈련 정확도와 검증 정확도가 가깝게 유지되는 것은, 훈련과 검증 과정에서 비슷한 정확도를 보인다는 것.

이 말은 과대적합 징후가 없다는 것이다.

이제 이걸 이용해서 스팸을 가릴 수 있다.

3. 후기

내 맥미니로는 1.2B 돌리기도 벅차지만, 가능하다면 LLM을 훈련시켜서 여러 가지 것들을 할 수 있지 않을까 하는 생각이든다.

내년에 논문 쓸 때 이걸로 한번 해볼까 싶기도 하다.

얼른 책을 다 읽고, 그 다음 부터는 파이토치를 익혀 나가야겠다.

댓글을 불러오는 중...