講義を多く受けて感じるのは、講義を聞いて学ぶよりも自ら探求しながら学ぶ方が記憶に残りやすく、多くのことを学べるようになるということです。

そこでインフレンで『ゼロから作りながら学ぶLLM』の完全読了チャレンジが開催されるという話を聞き、すぐに申し込みました。

前回の航海99でアルゴリズムの重要性を悟ったように、今回も多くのことを学びたいです。

1. 内容の要約

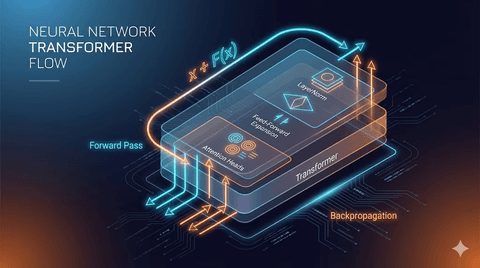

第1章の核心をまとめると、LLMの始まりはトランスフォーマー構造から始まるということ。

トランスフォーマー構造では、言語をエンコードし、ターゲット言語をデコードして訳された言語が出ます。

エンコーダーは言語をトークン化、ベクトル化する過程であり、デコーディングは言語を出力する過程です。

ここからデコードのみを取り出しプログラム化すると、GPTのようなサービスになります。GPTは文章が完成するまでデコーダーを繰り返し実行します。

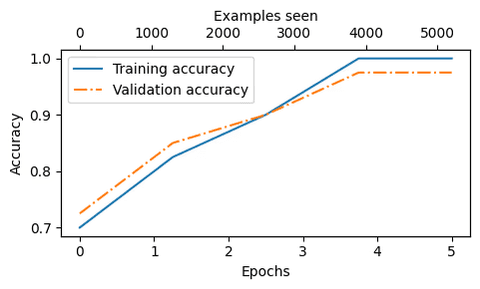

このような言語モデルを作るためには学習データが必要です。

オープンソースの学習データを活用しモデルを作り、これを微調整して様々なLLMサービスを作れます。

2. 感想

本を読みながらLLMの構造を正確に理解できました。

ベクトル化を学びながら出てきたBERT、エンコーディングのために使ったOne-Hot Encodingなども全て言葉のベクトル化手法の一つでした。

これひとつ学べただけでもチャレンジに参加した甲斐がありました。

第2章も精読後、もう一度試みたいと思います。

댓글을 불러오는 중...