El capítulo 6 trata sobre el fine-tuning para clasificación.

El ejemplo que aparece es la creación de un clasificador de spam.

Como el clasificador de spam debe determinar si algo es spam o no lo es, el resultado de la salida debe ser un valor como 0 o 1.

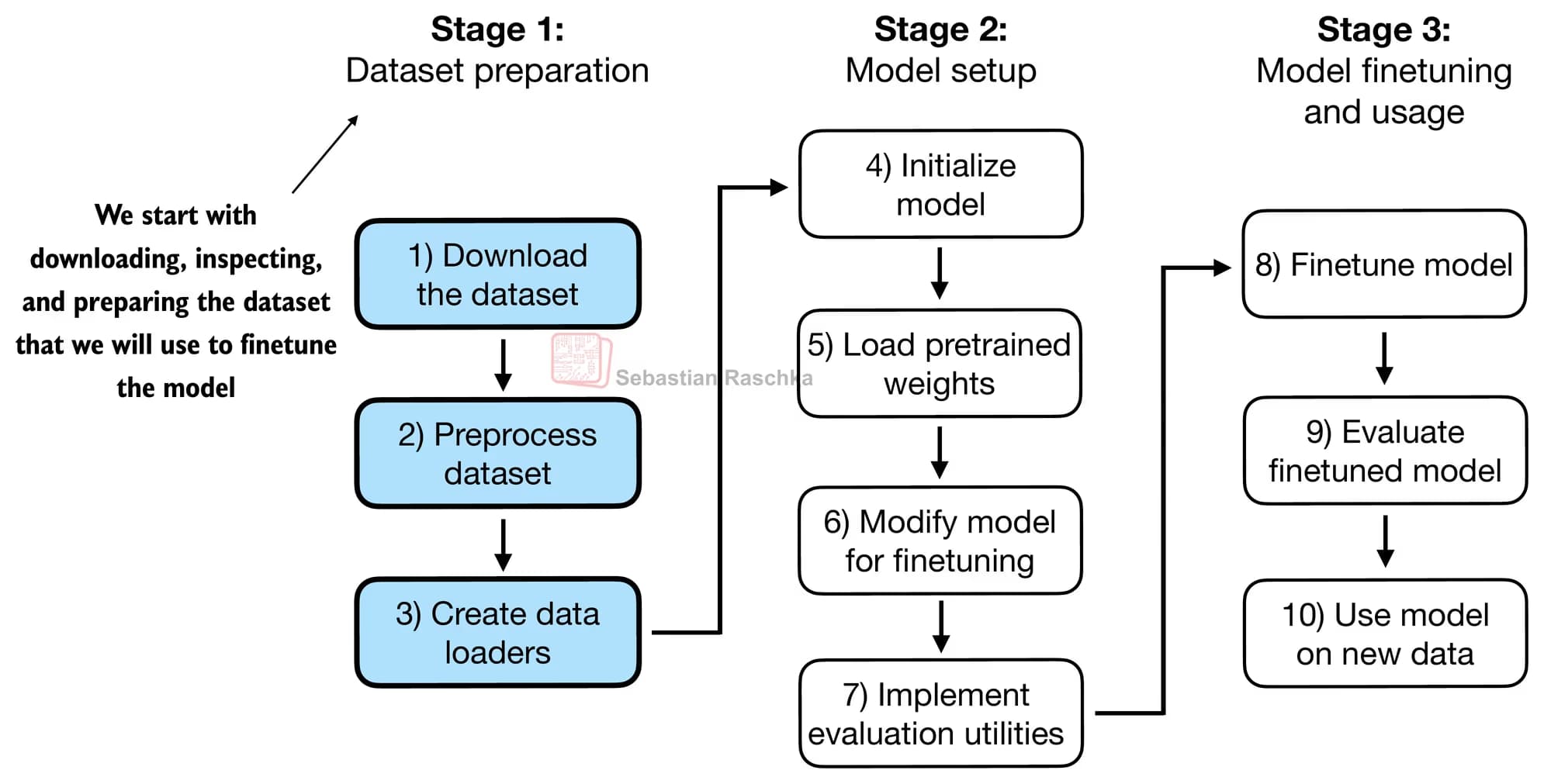

1. Orden del fine-tuning

El proceso de fine-tuning es similar al proceso de entrenamiento de un modelo.

Se prepara el conjunto de datos, se cargan los valores de los pesos, y luego se entrena y se evalúa.

La pequeña diferencia es que hay un proceso en el que la capa de salida se mapea a 0 (no es spam) y 1 (es spam).

Entre los tensores obtenidos, se utiliza el último tensor, que contiene la mayor cantidad de información, como base para producir la salida sobre si es spam o no.

Por último, la pérdida se calcula mediante entropía cruzada.

2. Fine-tuning del modelo con datos de aprendizaje supervisado

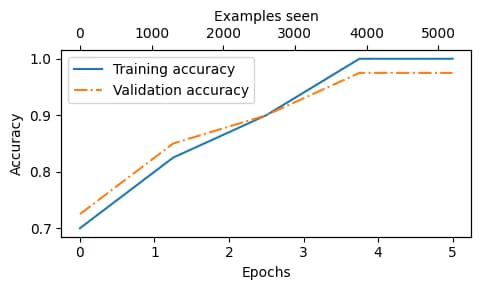

Se dividen los datos en datos de entrenamiento y datos de validación, y se entrenan a lo largo de varias épocas.

Que la exactitud de entrenamiento y la exactitud de validación se mantengan cercanas significa que muestran precisiones similares durante los procesos de entrenamiento y validación.

Esto implica que no hay señales de sobreajuste.

Ahora, usando esto, ya se puede distinguir el spam.

3. Reseña

Con mi Mac mini incluso ejecutar un modelo de 1.2B es bastante difícil, pero me hace pensar que, si fuera posible, podría entrenar un LLM y hacer muchas cosas con él.

También me planteo usarlo el año que viene cuando escriba un artículo.

Debería terminar de leer el libro pronto y, después de eso, empezar a aprender PyTorch.

댓글을 불러오는 중...