Ya es la segunda semana participando en el desafío.

Hasta ayer no había terminado el capítulo 2, pero aprovechando un retiro de 1 noche y 2 días, logré avanzar hasta la medianoche codificando.

1. Contenido

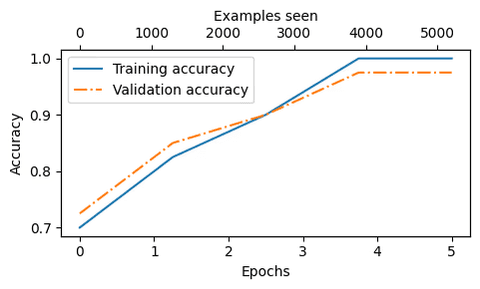

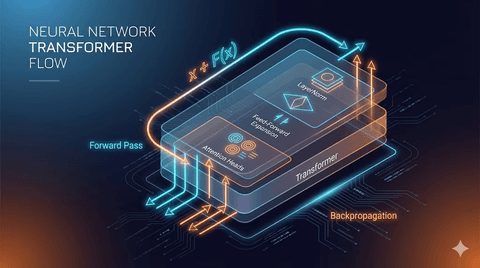

El contenido del capítulo 2 se centró en la tokenización de palabras, codificación, decodificación y vectores de incrustación.

Ya me había familiarizado con crear un codificador one-hot, pero el contenido de los vectores de incrustación era nuevo para mí.

El codificador one-hot crea una matriz tridimensional para cada palabra y establece esa parte en 1, mientras que los vectores de incrustación se representan como vectores en un espacio tridimensional como x, y, z.

2. Preguntas

Al trabajar con vectores de incrustación, surgieron varias preguntas.

¿Por qué inicialmente los vectores de incrustación se crean como números aleatorios no sobrepuestos usando una seed?

¿Por qué se dice que la matriz es tridimensional si parece bidimensional?

¿Cuál es la razón para sumar la incrustación de tokens con la incrustación de posiciones?

Resolví estas preguntas usando Chat-GPT.

El vector de incrustación actúa como un diccionario para encontrar palabras.

Inicialmente dar una seed al vector de incrustación asigna una función aleatoria para dispersar las ubicaciones de las palabras en el sistema de coordenadas.

Y si generas la incrustación con la misma seed, será igual a la incrustación inicial, haciendo que la posición de las palabras sea la misma.

Por lo tanto, al sumar la incrustación de tokens con la incrustación de posiciones, se muestran las características de la palabra junto con el contexto.

3. Reseña

Había visto vagamente sobre vectores de incrustación en el Vercel AI SDK, pero ahora lo entiendo claramente.

Si se intenta expresar matemáticamente puede ser bastante complicado, pero al comprender el significado, se puede abordar más fácilmente.

Tengo la intención de continuar consistentemente.

댓글을 불러오는 중...